AAAI 2026 | 北航、东京大学填补AI「语义鸿沟」,过程感知视频理解如何找到「状态」锚点?

AAAI 2026 | 北航、东京大学填补AI「语义鸿沟」,过程感知视频理解如何找到「状态」锚点?在具身智能与视频理解飞速发展的今天,如何让 AI 真正 “看懂” 复杂的操作步骤?北京航空航天大学陆峰教授团队联合东京大学,提出视频理解新框架。该工作引入了 “状态(State)” 作为视觉锚点,解决了抽象文本指令与具象视频之间的对齐难题,已被人工智能顶级会议 AAAI 2026 接收。

在具身智能与视频理解飞速发展的今天,如何让 AI 真正 “看懂” 复杂的操作步骤?北京航空航天大学陆峰教授团队联合东京大学,提出视频理解新框架。该工作引入了 “状态(State)” 作为视觉锚点,解决了抽象文本指令与具象视频之间的对齐难题,已被人工智能顶级会议 AAAI 2026 接收。

2025 年 12 月,硅谷风险投资机构 Andreessen Horowitz(简称 a16z)与 AI 推理服务平台 OpenRouter 联合发布了一份名为《State of AI》的研究报告。这份报告基于 OpenRouter 平台上超过 100 万亿 token 的真实用户交互数据,试图呈现过去一年间大语言模型在实际应用中的真实状态。

来自中国的初创团队词元无限给出了自己的答案。由清华姚班校友带队设计开发的编码智能体 InfCode,在 SWE-Bench Verified 和 Multi-SWE-bench-CPP 两项非常权威的 AI Coding 基准中双双登顶,力压一众编程智能体。

近日,AI 初创公司 Axiom 宣布其模型在没有人类干预的情况下,自动完成了两个数学猜想的证明——埃尔德什问题(Erdős Problem)中的 481 号和 124 号。据称,481 号问题仅用时 5 小时,代码量为 656 行;124 号问题则耗时超 24 小时。值得关注的是,这些证明均通过 Lean 验证,Lean 的特点是其形式化证明过程无需人工干预,为数学正确性提供了保障。

游戏进入下半场,阿彪说,他想让 Pollo AI 成为 AI 时代的剪映。

“帮助全世界 40 万人成为导演,这种成就感,比我自己拍一部电影要大得多。”

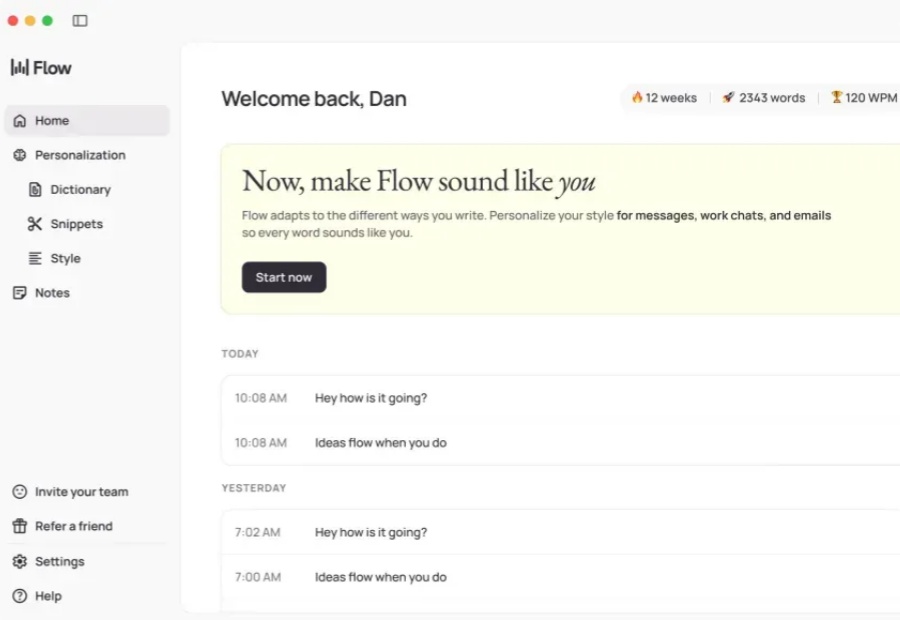

键盘作为人机交互的主要工具,实质上是一个巨大且不自然的「输入、输出瓶颈」。在「后键盘时代(post-keyboard future)」,语音或许才是最好地交互方式。

在生成式 AI 的新时代,人们一直在讨论它会不会颠覆教育、改变编程、重塑工作方式——但你可能没想到:现在连 6 岁的小孩都能通过AI 变成“侵权生成器”了。

去年,美国有49家AI创业公司完成了1亿美元以上的融资。按常理,这样的数字意味着高基数、难再现。但今年的市场依旧火热,据TechCrunch的最新发布,进入年底前的最后几周,2025年已经追平去年,甚至出现更多的头部公司连续获得多轮 1亿美元以上的融资。

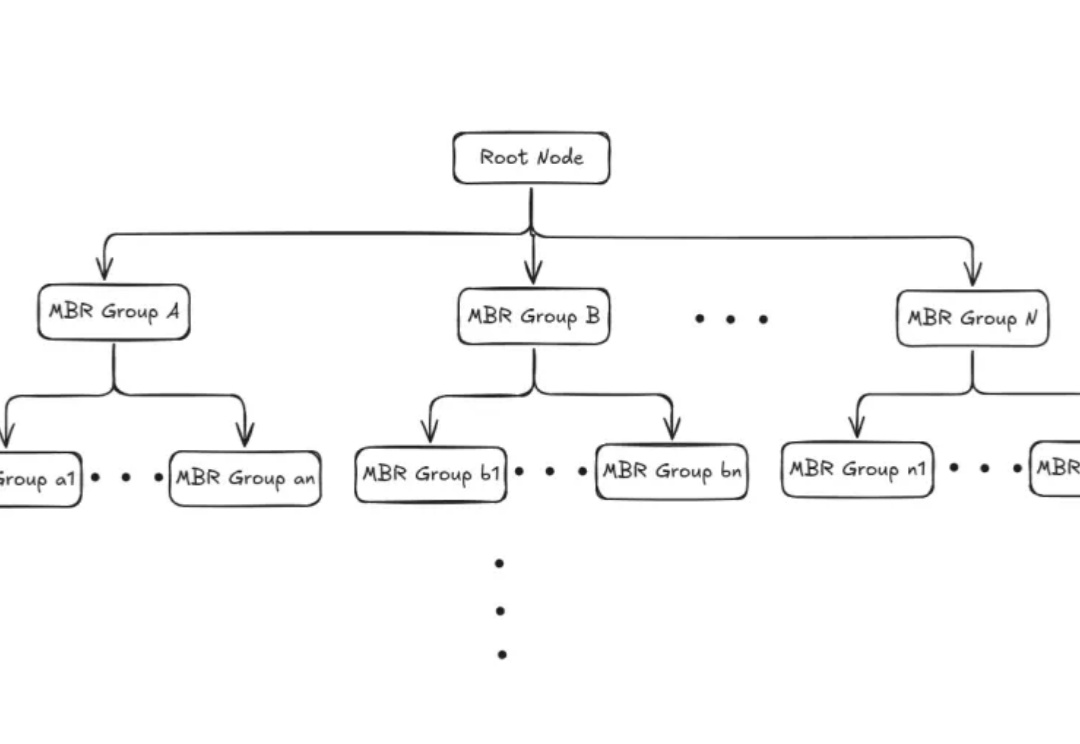

本文为Milvus Week系列第三篇,该系列旨在分享Milvus的创新与实践成果,以下是DAY3内容划重点: Milvus2.6中,Zilliz借助Geolocation Index for Milvus,首次将地理空间数据与向量检索融合,使 AI 可以在理解语义的同时,理解空间。